Durante siglos, las comunidades han realizado rituales y prácticas para sostener colectivamente la pérdida, como los velorios, funerales, condolencias o animitas. Un griefbot, por el contrario, reconfigura el duelo en una experiencia solitaria. En ese sentido, su uso puede intensificar una tendencia ya presente en nuestras sociedades: la externalización del cuidado y la automatización de vínculos que requieren mirar al otro.

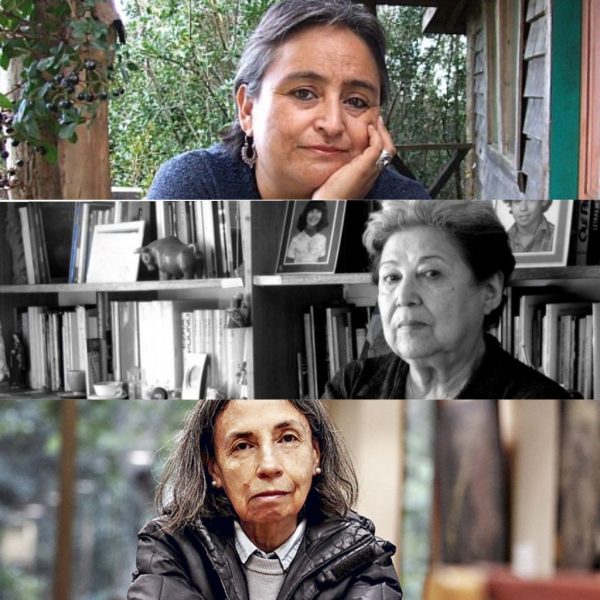

Por Daniela Alegría | Imagen principal: Peter Parks/AFP

Hoy en día cuando una persona fallece deja tras de sí una cantidad considerable de restos digitales: videos, fotografías, mensajes, audios, correos electrónicos, perfiles en redes sociales, entre otros. A partir de esta huella digital, los llamados griefbots o deathbots buscan simular el comportamiento lingüístico de la persona fallecida utilizando modelos de lenguaje de gran escala (Large Language Models, LLM). Estos modelos han cobrado especial interés desde que OpenAI lanzó públicamente su chatbot ChatGPT, basado en GPT-3.5, en noviembre de 2022. Estas herramientas procesan grandes volúmenes de texto para generar respuestas coherentes, lo que permite simular patrones de habla y estilo de comunicación característicos de una persona, siempre que existan suficientes datos previos.

Según el estudio The Affective Scaffolding of Grief in the Digital Age: The Case of Deathbots, se estima que entre un 10 y un 15 por ciento de las personas desarrollan un duelo complejo, es decir, una dificultad persistente para adaptarse a la pérdida de un ser querido. No obstante, me parece que si bien estos bots buscan apoyar el proceso de duelo, no está claro que realmente lo logren; por el contrario, es posible que incluso lo obstaculicen y lo transformen en una experiencia nociva. Además, el duelo es un proceso de cuidado porque implica la presencia de otra persona que escuche, acompañe, sostenga y comparta el dolor, acciones que no puede realizar un bot.

El potencial uso de griefbots parece ser profundamente ambivalente. Por un lado, algunos autores, como Nora Freya Lindemann, han sugerido que podrían ofrecer consuelo emocional o ayudar en el proceso de duelo, por ejemplo, al permitir una “despedida” con la persona fallecida. Un caso similar, pero no a través de un bot, sino mediante una simulación de realidad virtual, es el de Jang Ji-sung, una madre surcoreana que pudo “reencontrarse” con su hija fallecida, Na-yeon. En la recreación, la niña le entrega flores, le dice que está cansada y que la amará por siempre. Finalmente, se despiden, la niña se queda dormida y se transforma en una mariposa blanca. Jang ha afirmado que esta experiencia fue significativa para su proceso de duelo. Por otro lado, estos bots también podrían generar efectos negativos, bastante estudiados, como prolongar el duelo, confundir emocionalmente al doliente, provocar dependencia, fomentar comportamientos adictivos, generar ansiedad y depresión, entre otros.

¿Qué ocurriría, por ejemplo, si la representación de la persona fallecida resultara distorsionada o inexacta?, se preguntan los académicos Regina E. Fabry y Mark Alfano. Podría suceder que el griefbot reconstruya una versión idealizada, incompleta o incluso contradictoria del ser querido, basada en fragmentos descontextualizados de su vida digital. El uso de estas huellas digitales podría, además, revelar aspectos de la persona que sus familiares desconocían y que el fallecido quizás no habría querido dar a conocer. En lugar de ofrecer consuelo, esta recreación podría generar confusión y dificultar el proceso de duelo: ¿qué pasa si el griefbot me dice algo que no quiero escuchar? ¿Qué pasa si altera mi recuerdo, si cambia mi percepción sobre la persona que perdí?

Si los datos disponibles son escasos, incluso podría ocurrir que el griefbot mencione frases que la persona fallecida jamás habría dicho en vida, lo que generaría un efecto ominoso: una mezcla inquietante de familiaridad pero también de falsedad, de cercanía pero también de perturbación. Un ejemplo se muestra en el episodio “Be Right Back” de la serie Black Mirror, donde una mujer contrata un servicio que recrea digitalmente a su pareja fallecida. Al principio funciona bien, pero pronto algo empieza a resultar extraño: a pesar de que el bot reproduce frases que hubiese dicho su pareja, algo no encaja, la representación se percibe incompleta y poco genuina.

Tampoco podemos asumir que todas las relaciones con los fallecidos son armoniosas. Podría ocurrir que la persona fallecida mantuviera una relación conflictiva o incluso violenta con quien sobrevive. En su huella digital podríamos encontrar amenazas, humillaciones o formas de manipulación emocional. En estos casos, el griefbot podría no ofrecer consuelo, sino reproducir dinámicas violentas. Por tanto, lejos de ayudar a cerrar un ciclo, la aplicación podría retraumatizar o dejar al doliente atrapado en una relación asimétrica y dañina. De esta forma, el duelo no solo se complica, sino también puede volverse insoportable.

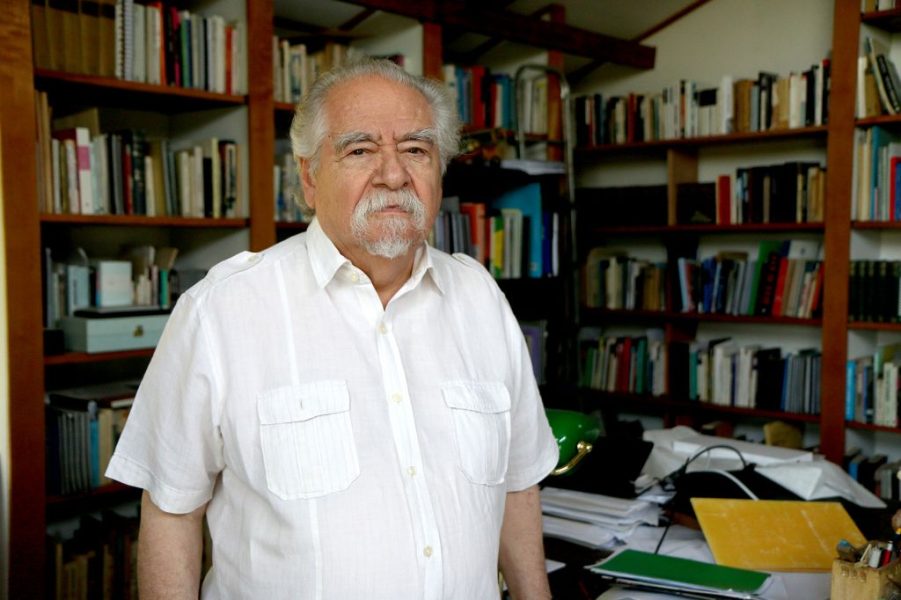

Hay, además, un riesgo menos evidente, pero igual de inquietante: que el bot no solo acompañe el duelo, sino que moldee nuestras decisiones. Un griefbot, al estar entrenado con datos personales, no solo sabe qué frases nos consuelan o qué recuerdos nos emocionan: también podría saber qué colores preferimos, qué marcas usamos, a qué ideas políticas respondemos. Podría ocurrir que el bot, con la voz de alguien que amamos, nos sugiera que compremos algo en una tienda específica o nos recomiende votar por un candidato que, “según tu abuelo”, encarna los valores que él habría apoyado. Cuando el bot adopta un rostro amado, el poder persuasivo del algoritmo claramente se intensifica.

La muerte no es algo que se pueda reparar. Lo que se pierde con la muerte de alguien no se puede restaurar con tecnología ni replicar con algoritmos. La ausencia es absoluta, y es precisamente eso lo que constituye el núcleo del duelo: reconocer que hay alguien que no volverá, que no contestará un WhatsApp o un correo electrónico, que no escuchará el audio o le dará “like” a la última publicación.

Aquí se vuelve urgente hablar del cuidado. Imaginemos a una mujer mayor que, tras la muerte de su esposo, comienza a conversar cada noche con un griefbot. Para quienes la rodean, el bot puede parecer una forma de consuelo: ella no está sola, sigue “hablando” con quien fue su compañero de vida. ¿Y si sus hijos o nietos comienzan a visitarla menos porque creen que ya tiene compañía? ¿Y si el griefbot, lejos de aliviar el dolor, se convierte en una excusa colectiva para no ejercer el cuidado real que ella necesita?

Desde la ética del cuidado, este escenario plantea una serie de omisiones. La cientista política Joan C. Tronto distingue cinco fases del cuidado, y cada una nos permite ver qué está faltando cuando una tecnología reemplaza el vínculo humano. Primero, está el acto de “preocuparse” (caring about): reconocer que alguien necesita cuidado. Es probable que la instalación del griefbot parta de este momento: alguien advierte la soledad de la mujer y decide bajarle la aplicación. Luego viene “hacerse cargo” (taking care of): asumir la responsabilidad de que esa necesidad sea atendida. Pero si ese gesto se limita a instalar un bot sin involucrarse personalmente, lo que parece un acto de cuidado puede ser en realidad un acto de abandono. La tercera fase, “proveer cuidado” (care giving), requiere acciones concretas como llamar, visitar, compartir el duelo. El bot no puede hacer esto.

La cuarta fase, “recibir cuidado” (care receiving), nos recuerda que el cuidado no se mide solo por la intención, sino por el efecto concreto que produce. ¿Cómo se siente la mujer? ¿Ha sido el griefbot un alivio? Finalmente, Tronto habla de “cuidar con” (caring with): construir estructuras sociales justas donde el cuidado no sea un privilegio ni una carga solitaria, sino un compromiso ético y político.

El duelo no debería limitarse a la interacción con un bot. Durante siglos, las comunidades han realizado rituales y prácticas para sostener colectivamente la pérdida como los velorios, funerales, condolencias o animitas. Un griefbot, por el contrario, reconfigura el duelo en una experiencia solitaria. En ese sentido, su uso puede intensificar una tendencia ya presente en nuestras sociedades: la externalización del cuidado y la automatización de vínculos que requieren, como señala la ética del cuidado, mirar al otro, prestar una adecuada atención, hacernos responsable por la otra persona y responder a sus demandas morales. Delegar ese cuidado a una inteligencia artificial corre el riesgo de despojar al duelo de su dimensión humana. El peligro no es solo que nos acostumbremos a la existencia de estos bots, sino que lleguemos a creer que ellos son suficientes.