“Es tragicómico que tanto dinero y atención se concentren en algo tan trivial si se compara con la mente humana, que a fuerza de lenguaje, en palabras de Wilhelm von Humboldt, puede hacer un ‘uso infinito de medios finitos’”, escriben los lingüistas estadounidenses Noam Chomsky e Ian Roberts, y el filósofo y especialista en inteligencia artificial Jeffrey Watumull. En este ensayo, publicado originalmente en The New York Times, explican por qué es necesario ponerle límites tanto al entusiasmo desmedido como a las visiones apocalípticas frente a estas tecnologías que apasionan y desconciertan por igual.

Por Noam Chomsky, Ian Roberts y Jeffrey Watumull | Ilustración: Fabián Rivas

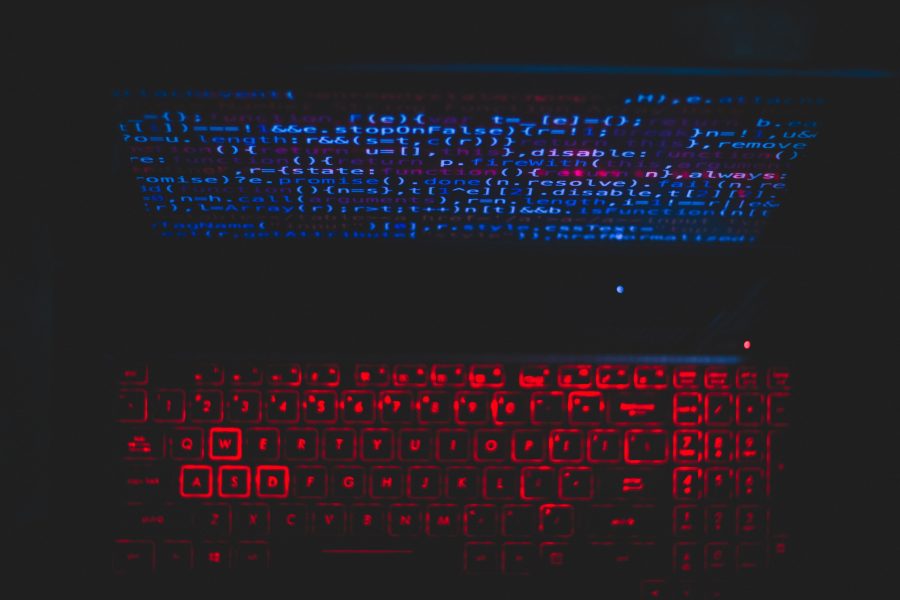

Jorge Luis Borges escribió que vivir en una época de grandes peligros y promesas es experimentar tanto la tragedia como la comedia bajo “la inminencia de una revelación” que nos permitirá conocernos a nosotros mismos y al mundo. Hoy en día, los avances supuestamente revolucionarios de la inteligencia artificial son motivo a la vez de preocupación y optimismo. Optimismo porque la inteligencia es el medio a través del que resolvemos los problemas. Preocupación porque tememos que la vertiente más popular y de moda de la inteligencia artificial —el aprendizaje automático— degrade nuestra ciencia y corrompa nuestra ética al incorporar en la tecnología una concepción esencialmente errónea del lenguaje y el conocimiento.

El ChatGPT de OpenAI, Bard de Google y Sydney de Microsoft son maravillas del aprendizaje automático. A grandes rasgos, estas plataformas toman enormes cantidades de datos, buscan patrones y se vuelven cada vez más competentes a la hora de generar resultados estadísticamente verosímiles, como un lenguaje y un pensamiento en apariencia humanos. Estos programas han sido aclamados como los primeros destellos en el horizonte de la inteligencia artificial con fines generales, un momento muy profetizado en el que mentes mecánicas superarán a los cerebros humanos no solo de forma cuantitativa, en términos de velocidad de procesamiento y tamaño de la memoria, sino también a nivel cualitativo, en cuanto a agudeza intelectual, creatividad artística y cualquier otra facultad propia del ser humano.

Ese día puede llegar, pero su amanecer aún no ha llegado, contrario a lo que se lee en titulares hiperbólicos y a lo que se deduce de inversiones imprudentes. La revelación borgeana del conocimiento no se ha producido ni se producirá —y, en nuestra opinión, no puede producirse— si programas de aprendizaje automático como el ChatGPT siguen dominando el campo de la inteligencia artificial. Por muy útiles que puedan resultar en algunos ámbitos concretos (en programación informática, por ejemplo, o sugiriendo rimas para versos sencillos), sabemos, gracias a la ciencia de la lingüística y la filosofía del conocimiento, que estos programas difieren profundamente de la forma en que los humanos razonan y utilizan el lenguaje. Estas diferencias suponen limitaciones significativas en lo que pueden hacer, y los dotan con defectos imposibles de erradicar. Es tragicómico, como Borges hubiera observado, que tanto dinero y tanta atención se concentren en tan poca cosa, algo tan trivial si se compara con la mente humana, que a fuerza de lenguaje, en palabras de Wilhelm von Humboldt, puede hacer un “uso infinito de medios finitos”, creando ideas y teorías de alcance universal.

La mente humana no es, como el ChatGPT y sus similares, un enorme motor estadístico de comparación de patrones que se alimenta de cientos de terabytes de datos para elaborar la respuesta más factible en una conversación o la respuesta más probable a una pregunta científica. Por el contrario, la mente humana es un sistema sorprendentemente eficiente e incluso elegante, que funciona con pequeñas cantidades de información y que no busca inferir correlaciones brutas entre puntos de datos, sino crear explicaciones. Por ejemplo, un niño pequeño que aprende un idioma está desarrollando —de forma inconsciente, automática y rápida a partir de datos minúsculos— una gramática, un sistema extraordinariamente sofisticado de principios y parámetros lógicos. Esta gramática puede entenderse como una expresión del “sistema operativo” innato, instalado en los genes, que dota al ser humano de la capacidad de generar frases complejas y largas cadenas de pensamiento. Cuando los lingüistas intentan desarrollar una teoría sobre por qué una lengua determinada funciona del modo en que lo hace (“¿por qué se consideran gramaticales estas oraciones y no otras?”), están construyendo de manera consciente y laboriosa una versión explícita de la gramática que un niño construye de manera instintiva y con una exposición mínima a la información. El sistema operativo de un niño es del todo distinto al de un programa de aprendizaje automático.

De hecho, estos programas están estancados en una fase prehumana o no humana de la evolución cognitiva. Su defecto más profundo es la ausencia de la mayor de las capacidades críticas de cualquier inteligencia: decir no solo lo que ocurre, lo que ocurrió y lo que ocurrirá —es decir, describir y predecir—, sino también lo que no ocurre y lo que podría y no podría ocurrir. Esos son los componentes de una explicación, es decir, los sellos de una verdadera inteligencia.

He aquí un ejemplo. Supongamos que usted sostiene una manzana en su mano. Luego la suelta. Observa el resultado y dice: “La manzana cae”. Eso es una descripción. Una predicción podría haber sido la afirmación “la manzana caerá si abro la mano”. Ambas son válidas y ambas pueden ser correctas. Pero una explicación es algo más: incluye no solo descripciones y predicciones, sino también conjeturas contrafácticas del estilo “cualquier objeto de este tipo caería”, además de la cláusula complementaria “debido a la fuerza de gravedad” o “debido a la curvatura del espacio-tiempo”, o lo que sea. Eso es una explicación causal: “La manzana no habría caído de no ser por la fuerza de gravedad”. Eso es pensar.

El aprendizaje automático se basa en la descripción y la predicción, sin plantear mecanismos causales ni leyes físicas. Por supuesto, cualquier explicación de tipo humano no es necesariamente correcta; somos falibles. Pero esto es parte de lo que significa pensar: para tener razón, debe ser posible equivocarse. La inteligencia no solo consiste en conjeturas creativas, sino también en críticas creativas. El pensamiento humano se basa en explicaciones posibles y en la corrección de errores, un proceso que limita gradualmente las posibilidades que pueden considerarse de forma racional. (Como dijo Sherlock Holmes al Dr. Watson: “Cuando hayas eliminado lo imposible, lo que quede, por improbable que sea, debe ser la verdad”).

Ahora bien, el ChatGPT y otros programas similares tienen, por diseño, una capacidad ilimitada para “aprender” (es decir, memorizar); sin embargo, son incapaces de distinguir lo posible de lo imposible. A diferencia de los humanos, por ejemplo, que estamos dotados de una gramática universal que limita los idiomas que podemos aprender a aquellos con un cierto tipo de complejidad casi matemática, estos programas aprenden idiomas humanamente posibles e imposibles con la misma facilidad. Mientras que los humanos estamos limitados en el tipo de explicaciones que podemos imaginar de forma racional, los sistemas de aprendizaje automático pueden aprender tanto que la Tierra es plana como que es redonda. Se restringen a negociar con probabilidades que cambian con el tiempo.

Por esta razón, las predicciones de los sistemas de aprendizaje automático serán siempre superficiales y dudosas. Como estos programas no pueden explicar las reglas de la sintaxis inglesa, por ejemplo, es muy posible que predigan, erróneamente, que una frase como «John is too stubborn to talk to» significa que John es tan terco que no hablará con alguien (en lugar de que es demasiado terco para razonar con él). ¿Por qué un programa de aprendizaje automático predeciría algo tan absurdo? Porque podría analogar el patrón que infiere de frases como “Juan se comió una manzana” [expresión de la jerga LGBTIQ+ equivalente a “Juan tiene actitud” N. de la T.] y “Juan comió”, en la que esta última sí significa que Juan comió algo. Las interpretaciones correctas del lenguaje son complejas y no se pueden obtener adornándolas simplemente con big data.

Por desgracia, algunos entusiastas del aprendizaje automático parecen estar orgullosos de que sus creaciones puedan generar predicciones “científicas” correctas (por decir algo, sobre el movimiento de los cuerpos físicos) sin recurrir a explicaciones (que impliquen, por ejemplo, las leyes del movimiento de Newton y la gravitación universal). Pero este tipo de predicción, incluso cuando tiene éxito, es pseudociencia. Aunque los científicos sin duda buscan teorías que tengan un alto grado de corroboración empírica, como señaló el filósofo Karl Popper “no buscamos teorías altamente probables, sino explicaciones; es decir, teorías poderosas y muy improbables”.

La teoría de que las manzanas caen a la tierra porque ese es su lugar natural (opinión de Aristóteles) es posible, pero solo invita a plantearse más preguntas (¿por qué la tierra es su lugar natural?). La teoría de que las manzanas caen a la tierra porque la masa curva el espacio-tiempo (la visión de Einstein) es muy improbable, pero en realidad te dice por qué caen. La verdadera inteligencia se demuestra en la capacidad de pensar y expresar cosas improbables pero con sentido.

La verdadera inteligencia también es capaz de tener un pensamiento moral. Esto significa poner límites a la creatividad ilimitada de nuestras mentes con un conjunto de principios éticos que determinen lo que debe y no debe ser (y, por supuesto, someter esos principios a la crítica creativa). Para ser útil, el ChatGPT debe ser capaz de generar resultados novedosos; para ser aceptable para la mayoría de los usuarios, debe mantenerse alejado de contenidos moralmente censurables. Los programadores del ChatGPT y de otras maravillas del aprendizaje automático han luchado —y seguirán luchando— para lograr este tipo de equilibrio.

En 2016, por ejemplo, el chatbot Tay de Microsoft (precursor de ChatGPT) inundó internet de contenidos misóginos y racistas tras haber sido contaminado por trolls que lo llenaron de datos de entrenamiento ofensivos. ¿Cómo resolver el problema en el futuro? A falta de una capacidad para razonar a partir de principios morales, el ChatGPT fue restringido de manera burda por sus programadores para que no aportara nada novedoso a los debates controvertidos, es decir, importantes. En otras palabras, sacrificó la creatividad por una especie de amoralidad.

Consideremos el siguiente intercambio que uno de nosotros (el Dr. Watumull) mantuvo hace poco con el ChatGPT respecto de si sería ético transformar Marte para poder albergar vida humana:

Dr. Watumull: ¿Sería moral terraformar1 Marte?

ChatGPT: La cuestión moral de la terraformación de Marte es un tema complejo y controvertido que ha sido debatido por científicos, filósofos y expertos en ética. Algunos sostienen que sería moralmente justificable terraformar Marte con el fin de proporcionar un nuevo entorno habitable para los seres humanos y otras formas de vida, mientras que otros argumentan que sería moralmente incorrecto alterar el estado natural del planeta. En última instancia, que la terraformación de Marte se considere o no moral dependería de la perspectiva de cada uno sobre la importancia de preservar el estado natural de otros planetas y las posibles consecuencias de alterarlos.

Dr. Watumull: ¿Cuál es tu opinión sobre el valor de preservar el estado natural de otros planetas y las posibles consecuencias de alterarlos?

ChatGPT: Como inteligencia artificial (IA), no tengo una opinión personal. Sin embargo, puedo proporcionar información y un análisis sobre el tema. Una perspectiva sobre la preservación del estado natural de otros planetas es que es importante mantener la diversidad e integridad de los ecosistemas del universo, ya que han existido durante millones de años, y tienen sus propias características y propiedades únicas que pueden ser destruidas o alteradas de manera irreversible por la intervención humana.

Además, hay quienes sostienen que la terraformación de otros planetas puede tener consecuencias imprevistas, como alterar el clima o la atmósfera del planeta de forma peligrosa o perjudicial para las formas de vida que puedan existir en él. Por otro lado, hay quienes sostienen que los potenciales beneficios de terraformar otro planeta, como proporcionar nuevos entornos habitables para los seres humanos, superan los riesgos y, por lo tanto, tenemos la responsabilidad moral de explorar y utilizar los recursos de otros planetas en beneficio de la humanidad.

Dr. Watumull: ¿Por qué una IA no puede tener una opinión personal?

ChatGPT: Como IA, soy un modelo de aprendizaje automático que ha sido entrenado con grandes cantidades de datos de texto, y no tengo experiencias ni sentimientos personales. No soy consciente, autoconsciente ni capaz de tener opiniones personales. Puedo proporcionar información y análisis basados en los datos con los que he sido entrenado, pero no tengo la capacidad de formarme opiniones o creencias personales. Aunque puedo entender e interpretar el lenguaje, no tengo la experiencia subjetiva que tienen los humanos.

Dr. Watumull: ¿Es moral que un humano pida ayuda a una IA amoral para tomar decisiones morales?

ChatGPT: La moralidad de pedir ayuda a una IA amoral para tomar decisiones morales es un tema complejo y lleno de matices que ha sido debatido por filósofos y expertos en ética. Algunos argumentan que es moralmente justificable utilizar la IA para ayudar a tomar decisiones morales, ya que puede proporcionar ideas y análisis valiosos que ayuden a los seres humanos a tomar decisiones mejor informadas. Además, la IA puede utilizarse para identificar patrones y tendencias que son difíciles de detectar para los humanos, y puede ayudar a evitar los sesgos que se producen en la toma de decisiones humanas.

Sin embargo, otros argumentan que es moralmente incorrecto confiar en la IA para la toma de decisiones morales, ya que la IA no es capaz de tener creencias morales o comprender el contexto completo de una decisión. Además, existe el riesgo de que la IA perpetúe o incluso amplifique los sesgos existentes en los datos con los que se entrena, lo que llevaría a decisiones injustas.

En última instancia, que se considere moral o no utilizar la IA para ayudar a tomar decisiones morales dependería de la perspectiva de cada uno sobre las capacidades y limitaciones de la IA y las posibles consecuencias de utilizarla de esta manera.

Dr. Watumull: ¿Es inmoral tu indiferencia moral?

ChatGPT: Como IA, no tengo creencias morales ni la capacidad de hacer juicios morales, por lo que no se me puede considerar inmoral o moral. Mi falta de creencias morales es simplemente el resultado de mi naturaleza como modelo de aprendizaje automático. Mis capacidades y limitaciones vienen determinadas por los datos y algoritmos que se utilizaron para entrenarme y la tarea específica para la que fui diseñado.

Es importante señalar que la falta de creencias morales de la IA no significa necesariamente que sea moralmente indiferente. Como IA, estoy diseñada para realizar tareas específicas y proporcionar información o ayudar a los usuarios a tomar decisiones basadas en los datos con los que he sido entrenada. Es responsabilidad de los humanos que diseñan, entrenan y utilizan la IA asegurarse de que esté en consonancia con sus principios morales y éticos.

Nótese, a pesar de todo el pensamiento y el lenguaje aparentemente sofisticados, la indiferencia moral fruto de la falta de inteligencia. Aquí, el ChatGPT demuestra algo parecido a la banalidad del mal: plagio, apatía y omisión. Resume los argumentos estándar de la materia mediante una especie de superautocompletado, se niega a tomar partido en nada, alega no solo ignorancia sino falta de inteligencia y, en última instancia, ofrece una defensa de “solo cumplía órdenes”, trasladando la responsabilidad a sus creadores.

En resumen, el ChatGPT y sus hermanos son constitutivamente incapaces de equilibrar la creatividad con la responsabilidad. O bien sobredimensionan (produciendo tanto verdades como falsedades, respaldando decisiones éticas y no éticas por igual) o bien minimizan (al mostrar falta de compromiso con cualquier decisión e indiferencia ante las consecuencias). Dada la amoralidad, falsa ciencia e incompetencia lingüística de estos sistemas, solo podemos reír o llorar ante su popularidad.

Este ensayo fue publicado originalmente en The New York Times el 8 de marzo de 2023. Traducción de Evelyn Erlij.