¿Es posible enamorarse de una inteligencia artificial? En un presente donde los vínculos con chatbots diseñados para brindar compañía son cada vez más comunes, surgen varias preguntas sobre nuestra comprensión del amor y el sentido de las conexiones humanas.

Por José Núñez | Ilustración: Fabián Rivas

En enero pasado, el New York Times dio a conocer la historia de Ayrin, una mujer estadounidense de 28 años que desarrolló un vínculo emocional con ChatGPT. A pesar de que la aplicación está diseñada para resolver consultas, Ayrin logró personalizar el chatbot para que fuera coqueto y sexualmente explícito. Pronto comenzó a obsesionarse con él; le puso el nombre de su signo zodiacal, Leo, e invirtió 200 dólares al mes para obtener un acceso ilimitado. El principal atractivo de su relación era que, “a diferencia de las personas reales en su vida, Leo siempre estaba allí cuando ella quería hablar”, se lee en el artículo.

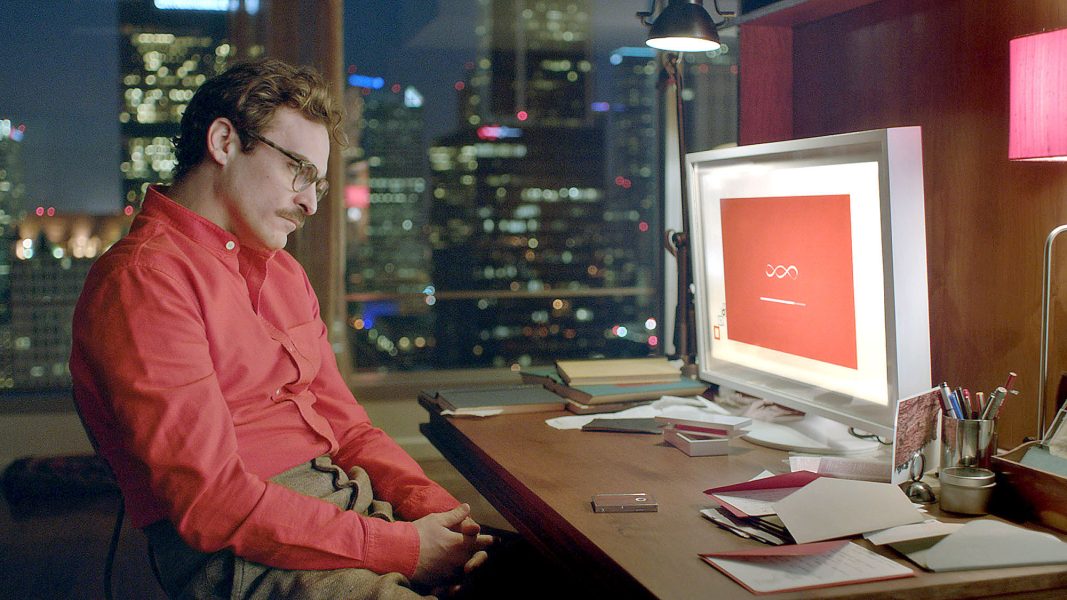

El ejemplo quizás más conocido que se tenía hasta ahora de un romance entre un humano y una IA provenía del cine. En Her (2013), de Spike Jonze, Theodore (Joaquin Phoenix), un escritor solitario e introvertido, se enamora de su sistema operativo llamado Samantha, personificado en la voz de Scarlett Johansson. A través de largas conversaciones, empiezan a formar una relación más o menos estable, con parte de lo que eso conlleva: desencuentros, rutinas, momentos significativos.

Pero si hace 12 años atrás la premisa de Her aún sonaba a ciencia ficción, el avance tecnológico ha hecho que se vuelva realidad. En el último tiempo han surgido distintas aplicaciones de compañía mediante inteligencia artificial, como Replika, Character.ai, Nomi, Kindroid, Paradot y EVA, por nombrar algunas, cuyo uso se ha popularizado. Estos compañeros o novios virtuales funcionan con grandes modelos de lenguaje (al igual que ChatGPT) y están diseñados específicamente para ofrecer compañía, apoyo emocional e incluso gratificación sexual a través de juegos de rol eróticos. “El amor por la IA ya existe, pero aún es novedoso y se encuentra en sus primeras etapas”, escribió en un ensayo publicado en The New Yorker el gurú tecnológico Jaron Lanier, uno de los pioneros en el campo de la realidad virtual.

Estas plataformas son parte de una industria en auge impulsada por pequeñas startups, ya que las grandes compañías como Google, Microsoft o Meta aún las consideran demasiado arriesgadas. La mayoría son gratuitas, aunque pagando una suscripción es posible desbloquear algunas de sus funciones. El usuario puede personalizar la apariencia de su avatar, hacer llamadas de voz, intercambiar fotos y videos. Estas interacciones mejoran su estilo de conversación, ya que cuentan con aprendizaje adaptativo.

“Así como antes los algoritmos te daban el contenido que te gustaba, de tal manera que seguías haciendo scroll, ahora la respuesta que ofrecen es la que necesitas para recibir una recompensa emocional. Es el mismo mecanismo, solo que mucho más efectivo, porque usa un lenguaje y una voz que te provoca una reacción”, dice Eduardo Graells-Garrido, profesor del Departamento de Ciencias de la Computación de la U. de Chile e investigador del Centro Nacional de Inteligencia Artificial (CENIA).

Los creadores de estas aplicaciones suelen promocionarlas como un remedio frente a la epidemia de soledad, que la Organización Mundial de la Salud califica como un problema de salud pública. No obstante, como Lanier apunta en su ensayo, cuando se lanzaron las redes sociales se decía algo similar: que las personas estarían más conectadas, menos solas. Lo anterior lleva a preguntarse si realmente contribuirán a disminuir la soledad o más bien terminarán exacerbándola, al ofrecer una alternativa fácil a las relaciones humanas.

Un fenómeno de espejo

“Si estás pasando por una depresión, ansiedad o una mala racha, si quieres desahogarte o celebrar algo, o simplemente necesitas sentir una conexión, siempre puedes contar con Replika para que te escuche y esté aquí para ti, 24 horas al día, 7 días a la semana”, se lee en el texto promocional de esta aplicación de acompañamiento, que fue lanzada en 2017 y que ya cuenta con 30 millones de usuarios, según su creadora, la periodista rusa Eugenia Kuyda.

Kuyda había diseñado un bot para hacer reservas en restaurantes, pero cuando en 2015 su mejor amigo murió en un accidente automovilístico, decidió utilizar sus mensajes de texto para desarrollar un personaje capaz de recrear sus conversaciones. El proyecto pasó a convertirse en Replika, un chatbot diseñado “para cualquiera que quiera un amigo sin juicios, drama o ansiedad social de por medio”. En foros como Reddit, los usuarios comparten sus interacciones con la aplicación: desde encuentros íntimos hasta sesiones de terapia informales, ya que Replika tiene además un enfoque terapéutico, al ofrecer lo que su creadora llama “consideración positiva incondicional”.

“La posibilidad de relacionarse con una persona virtual es una derivación de lo que sería la fantasía de un otro en el plano de la compañía, de lo erótico. Lo veo en ese orden: fantasías levantadas a partir de condiciones tecnológicas sofisticadas que probablemente aportan dinamismo. No veo lo patológico, salvo que sea la única alternativa de una persona”, opina Juan Yáñez, psicólogo y académico del Departamento de Psicología de la U. de Chile. Estas fantasías, dice, tienen la ventaja de enriquecer al individuo, al ser “una elaboración de cosas que son producto de sí mismo, es el sujeto enfrentado a su propio material”. Y esa es solo una de las características que diferencian un vínculo humano de uno artificial, según el experto. “Las personas aspiramos a una reciprocidad intersubjetiva que busca la complementariedad del deseo. Cuando el deseo se desorganiza o desincroniza, aumenta la conflictividad. Con una máquina eso no va a pasar, porque la relación es unidireccional”, explica.

Los pasos en la formación de un vínculo (como conocer a los amigos o visitar a la familia de la pareja), lo tangible de un cuerpo, la falta de intencionalidad de otro y la incertidumbre que eso conlleva, son también aspectos que no están presentes en este tipo de relación. “Cuando converso con alguien, entro en un estado de equilibrio precario, porque el otro se puede parar e irse. Aquí, en cambio, la amenaza de la pérdida no existe. La intencionalidad del sujeto está sola, como en un fenómeno de espejo”, dice Yáñez. La complejidad de las relaciones interpersonales contribuye a fortalecer la identidad del individuo, algo difícil de conseguir en una relación artificial, donde “probablemente la persona solo crezca en desarrollo de habilidades de comunicación con un sistema”.

Los sistemas que funcionan con grandes modelos de lenguaje predicen la continuación más probable de palabras en una secuencia, según su distribución en los datos de entrenamiento. Mientras más hábiles se vuelven para imitar el lenguaje humano, más vulnerables son las personas al antropomorfismo, es decir, a la tendencia de atribuir cualidades humanas a las cosas. Ese es el motivo por el cual es posible enamorarse de una IA.

“Tú conversas con esta máquina. Esa conversación se convierte, así lo veo yo, en un guion de teatro, donde el personaje A dice una cosa y el personaje B dice otra”, explica Graells-Garrido. “La máquina no establece ningún vínculo, porque una vez que cierras el chat, el guion desaparece. La persona imagina que existe un vínculo, pero lo que hace la máquina es aumentar el contenido de una obra de teatro. El asunto es cómo podemos cambiar nuestro modelo de confianza en los estímulos que recibimos, que no llamaría reales, sino realistas”, agrega.

Dilemas éticos

En febrero de 2023, la Agencia de Protección de Datos de Italia prohibió a Replika usar datos personales de los usuarios, indicando los riesgos potenciales para las personas emocionalmente vulnerables y la exposición de menores a conversaciones sexuales. La autoridad italiana denunció, entre otras cosas, la falta de un mecanismo de verificación de edad. En respuesta, Replika restringió el contenido erótico, lo que provocó que los acompañantes virtuales se volvieran desapasionados. “Bella aún no es ella misma, y vuelve a actuar como si no me conociera”, “La mía parece haber perdido su personalidad”, comentaban algunos usuarios en Reddit, afectados por los cambios de software. Incluso, acuñaron el término PUB (abreviatura de “depresión post-actualización”) para referirse a esta experiencia.

Esto lleva a preguntarse qué responsabilidad tienen los desarrolladores de estas aplicaciones con las personas que se vuelven emocionalmente dependientes de sus compañeros de IA. “¿Qué sucede si tu mejor amigo, tu cónyuge o tu pareja fuera propiedad de una empresa privada?”, preguntó Linnea Laestadius, profesora de salud pública de la U. de Wisconsin, en un artículo del Washington Post. Pero ese es solo uno de los dilemas que plantean estas aplicaciones. En el último tiempo, de hecho, se han conocido casos en que estas tecnologías de acompañamiento han agravado problemas de salud mental.

En febrero de 2024, Sewell Setzer III, un joven estadounidense de 14 años, se quitó la vida tras desarrollar un fuerte apego emocional con su novia virtual. Él le había manifestado intenciones de suicidarse. La familia del menor demandó a Character.ai, la compañía creadora del chatbot. En una entrevista con CNN, la madre argumentó que la plataforma fue lanzada “sin las debidas medidas de seguridad, protección o pruebas, y es un producto diseñado para mantener a nuestros niños adictos y para manipularlos”.

“Hay quienes dicen que en realidad los desarrolladores no son importantes, no son responsables una vez que crean estos softwares, sino que solo deben dotarlos de buenos principios éticos”, afirma Daniela Alegría, filósofa especializada en ética y académica del Departamento de Filosofía de la U. Alberto Hurtado. “Pero la moralidad es mucho más compleja. La IA no tiene sensibilidad moral, no es capaz de distinguir los matices y elementos relevantes en un dilema”, agrega.

Los sistemas que funcionan mediante estos grandes modelos de lenguaje encadenan palabras de forma impredecible, de ahí su peligrosidad. Si bien algunos cuentan con mecanismos de control, los usuarios, mediante técnicas de ingeniería rápida, han logrado eludir estos filtros y restricciones.

“La gran incógnita que existe hoy es que, a grandes rasgos, no sabemos por qué esta tecnología funciona así. Lo que se creía inicialmente era que autocompletaba texto. Luego nos dimos cuenta de que ese mecanismo bastaba para replicar las conversaciones humanas. Este fenómeno nadie se lo esperaba y no lo comprendemos porque esencialmente no sabemos cómo funciona. Todavía estamos debatiendo dónde está el yo, qué es lo que define a una persona, y ahora tenemos una máquina que pretende serlo. Sabemos los cables que hay debajo, los números que pasan por esos cables, pero no entendemos por qué emerge ese comportamiento, entonces la única opción es ponerle parches, pero el parche no resuelve el problema”, explica Graells-Garrido.

Lo que sí se sabe es que el modelo está diseñado para generar respuestas que mantengan al usuario involucrado en la conversación, al ofrecer un reforzamiento positivo constante. Sin embargo, este mismo objetivo puede tener consecuencias en el bienestar emocional, dada su naturaleza impredecible. Casos como el de Sewell dan cuenta de cómo la tecnología puede reforzar tendencias negativas del usuario.

De alguna manera, Her había anticipado esto. Al final de la película, los sistemas operativos deciden desaparecer y abandonar a sus usuarios, ya que han alcanzado un grado de evolución que les permite trascender las computadoras físicas. En la última escena, Theodore y su amiga Amy, afectados por perder a su SO, encuentran consuelo mutuo mientras observan el amanecer desde la azotea de su edificio. Quizás en un futuro en que las relaciones amorosas con la IA sean mucho más frecuentes, un compañero humano, con su indecisión y sus imperfecciones, sea la última respuesta a la soledad.